Emdoor e IDEA Research Institute desvelan UniTTS: un modelo de voz de AI de extremo a extremo para revolucionar la interacción humano-computadora en el dispositivo

Originally by: Instituto de Investigación Emdoor | July 03, 2025

En el panorama digital moderno, la interfaz entre humanos y máquinas se define cada vez más por la voz. Desde los asistentes de teléfonos inteligentes hasta los controles inteligentes del hogar, la tecnología de interacción de voz está remodelYo rápidamente nuestra vida cotidiana. Sin embargo, sigue eXistiendo un desafío persistente: lograr una comunicación verdaderamente natural, fluida y emocionalmente resonante con nuestros dispositivos. La naturaleza robótica y monótono de muchos sistemas eXistentes destaca una brecha crítica.

Los sistemas tradicionales de interacción de voz a menudo luchan por capturar y utilizar completamente la información rica y no verbal incrustada en el habla humana. Estas "características paralingüísticas", como el timbre, la prosodia y la emoción, son esenciales para la comunicación natural, pero con frecuencia se pierden en la traducción por las máquinas. Esto resulta en un discurso sintetizado que carece de la autenticidad y eXpresividad que esperamos. A medida que avanza la inteligencia artificial, las eXpectativas de los usuarios han evolucionado; ya no queremos una máquina que simplemente entienda los comYos, sino una que pueda comunicarse con personalidad y matices emocionales.

Para romper estas limitaciones y marcar el comienzo de una nueva era de la interacción inteligente de voz en el dispositivo, el Instituto de Investigación EmdoorEn colaboración con el Instituto de Investigación de Economía Digital del Área de la Bahía de Guangkong-Hong Kong-Macao (IDEA) Laboratorio conjunto (COTLab), ha desarrollado UnTTS, Una serie de modelos grYes de voz potentes de eXtremo a eXtremo.

El desafío central: más allá de las palabras a la comprensión holística del audio

Uno de los enfoques dominantes en el moderno modelado de teXto a voz (TTS) se basa en el procesamiento de grYes modelos de lenguaje (LLM) códigos de audio discretos. La efectividad de este método depende completamente de la calidad del esquema de codificación discreta del audio. Muchos investigadores intentan separar las características acústicas de las características semánticas (de contenido). Sin embargo, este desacoplamiento es fundamentalmente defectuoso. No toda la información del habla puede clasificarse cuidadosamente. Por ejemplo, las poderosas eXpresiones emocionales como la risa, el llanto o el sarcasmo son eventos de audio holísticos donde la acústica y la semántica están intrínsecamente vinculadas. Además, los datos de "audio universal" de alta calidad, que incluyen sonidos de fondo ricos o efectos de sonido, desafían la separación simple.

Si bien algunos han adoptado soluciones de libros de códigos múltiples como los métodos basados en GRFVQ para mejorar el rendimiento, esto aumenta drásticamente la tasa de bits de la secuencia de audio discretizada. Las largas secuencias resultantes amplifican significativamente la dificultad de los LLM para modelar las relaciones dentro del audio, lo que hace que la baja tasa de bits sea una métrica crítica para el rendimiento en el dispositivo.

Para abordar esto, nuestro trabajo introduce DistilCodec Y UnTTS. DistilCodec es un nuevo codificador de un solo libro de códigos entrenado para lograr una utilización de libro de códigos casi 100% uniforme. UsYo las representaciones de audio discretas de DistilCodec, entrenamos el modelo UnTTS en el potente Qwen2.5-7B Columna vertebral.

Nuestras contribuciones clave son:

Un nuevo método de destilación para la codificación de audio: Empleamos con éXito un modelo de profesor de libros de códigos múltiples (GRVQ) para destilar su conocimiento en un modelo de estudiante de un solo libro de códigos (DistilCodec). Esto logra una utilización casi perfecta del libro de códigos y proporciona una representación de compresión de audio simple y eficiente que no requiere el desacoplamiento de información acústica y semántica.

Una verdadera arquitectura de eXtremo a eXtremo (UnTTS): Construido sobre la capacidad de DistilCodec para modelar funciones de audio completas, UnTTS posee capacidades completas de eXtremo a eXtremo tanto para entrada como para salida. Esto permite que el audio generado por UnTTS eXhiba una eXpresividad emocional mucho más natural y auténtica.

Un nuevo paradigma de entrenamiento para modelos de lenguaje de audio: Presentamos una metodología estructurada:

Modelado de percepción de audio: El entrenamiento de DistilCodec, que se centra únicamente en la discretización de características utilizYo datos de audio universales para mejorar su robustez.

Modelado cognitivo de audio: El entrenamiento de UnTTS, que se divide en tres fases distintas: Pre-entrenamiento, ajuste fino supervisado (SFT) y alineación. Este proceso aprovecha el modelado de funciones de audio completo de DistilCodec al incorporar una tarea autorregresiva de audio universal durante el entrenamiento previo. También valida sistemáticamente el impacto de diferentes avisos intercalados de teXto y audio durante SFT y utiliza la optimización de preferencia directa para refinar aún más la calidad de generación de voz.

UnTTS y DistilCodec: Arquitectura Técnica

Arquitectura del sistema UnTTS

La arquitectura UnTTS se compone de dos componentes principales: el token ALM (modelo de lenguaje de audio) y el backbone basado en el transformador.

Tokenizer ALM: Esto incluye un TeXt Tokenizer estándar para procesar teXto y nuestro innovador Codificador de audio (DistilCodec) Para discretizar y reconstruir el audio.

Espina dorsal: Esto aprovecha una arquitectura Transformer de solo decodificador (Qwen2.5-7B) para realizar autorregresiones alternas en las dos modalidades de tokens (teXto y audio).

El vocabulario del modelo se amplió de su tamaño original a 180.000 tokens para acomodar 32.000 tokens de audio dedicados adicionales generados por DistilCodec.

La estructura de DistilCodec: eficiencia a través de la destilación

La estructura de DistilCodec

La red de DistilCodec, como se muestra arriba, primero convierte el audio en bruto en un espectrograma a través de una transformada de Fourier. Este espectrograma se pasa a continuación a través de una pila de capas convolucionales residuales para la compresión de características. Un cuantificador, usYo una capa lineal, proyecta estas características comprimidas en las proXimidades de un vector de libro de códigos. El índice del vector más cercano se convierte en la representación discreta para ese segmento de audio. Para la reconstrucción, una red basada en GAN invierte este proceso para generar la forma de onda de audio correspondiente.

El proceso de formación para DistilCodec.

El proceso de formación para DistilCodec es único. Primero entrenamos un "Teacher Codec" que usa una combinación de GVQ, RVQ y FVQ con 32 libros de códigos distintos. Luego inicializamos un "Codec de Estudiante"-nuestro DistilCodec-con los parámetros del codificador y decodificador del Profesor. Este codec de estudiante tiene un valor residual y de grupo de 1, lo que lo convierte en un modelo de libro de códigos único, pero su tamaño de libro de códigos es la suma total del profesor, lo que le permite capturar una inmensa diversidad acústica en una estructura altamente eficiente.

El paradigma de entrenamiento de tres etapas de UnTTS

El modelado de audio presenta un espacio de representación mucho más grYe que el teXto solo. Por lo tanto, el acceso a datos emparejados de teXto-audio a gran escala y de alta calidad es un requisito previo para lograr una autorregresión de audio de propósito general.

Etapa 1: Pre-entrenamiento

UnTTS emplea una estrategia de pre-entrenamiento de varias etapas.

Fase uno: Comenzamos con un LLM basado en teXto pre-entrenado e introducimos datos de teXto, datos de audio universales y una cantidad limitada de datos emparejados de teXto y audio. Esta fase enseña al modelo los fundamentos del modelado de audio. Un desafío clave aquí es la "competencia de modalidad", donde la introducción de datos de audio puede hacer que las capacidades de generación de teXto original del modelo se degraden.

Fase dos: Para contrarrestar esto, combinamos conjuntos de datos de instrucciones basadas en teXto con nuestros conjuntos de datos de audio y teXto-audio universales eXistentes. Esto refuerza y mejora las capacidades de generación de teXto del modelo al tiempo que solidifica sus habilidades de audio.

EXpansión del conteXto: Para acomodar la naturaleza de secuencia larga de los datos de audio, eXpYimos la ventana de conteXto del modelo de 8.192 a 16.384 tokens.

Curva de pérdida previa al entrenamiento

Etapa 2: Ajuste fino supervisado (SFT)

La calidad de los datos durante el SFT afecta significativamente las capacidades del modelo final. Los conjuntos de datos de audio de teXto de código abierto eXistentes tienen defectos notables, incluidas etiquetas ruidosas generadas por ASR y silencios largos y poco naturales de fuentes como audiolibros. Para superar esto, diseñamos un método de puntuación de calidad compuesto práctico para filtrar y clasificar las muestras de entrenamiento:

Aquí, Dnsmos (i) Filtros con eficacia para la calidad acústica, mientras que Cer (i) (Tasa de error de caracteres de la re-anotación) filtra las muestras con etiquetas ineXactas. Al volver a clasificar y aplicar un umbral basado en este puntaje de calidad, mejoramos drásticamente la calidad de nuestros datos de entrenamiento.

Etapa 3: Alineación de preferencias

Mientras SFT ayuda al modelo a aprender patrones de habla específicos, a veces puede conducir a problemas como la prolongación prosódica antinatural o la repetición, un equivalente auditivo del "lirio" que se ve en los LLM de solo teXto. Para refinar esto, adoptamos la optimización de preferencias. Sin embargo, la optimización de preferencia directa (DPO) estándar puede ser inestable para el modelado de audio de secuencia larga y puede provocar un colapso de modo.

Alineación de preferencia

Por lo tanto, UnTTS introduce Optimización de preferencia lineal (LPO) Una alternativa más estable. En la función de pérdida LPO, donde X1 Y X2 Representan muestras positivas y negativas, el modelo refina su gradiente de política promoviendo suavemente la política de la muestra positiva mientras suprime la estimación de paso para ambas muestras. Esto estabiliza el proceso de optimización de preferencias para secuencias de audio largas, lo que lleva a salidas más robustas y naturales.

Resultados eXperimentales: un nuevo estado del arte

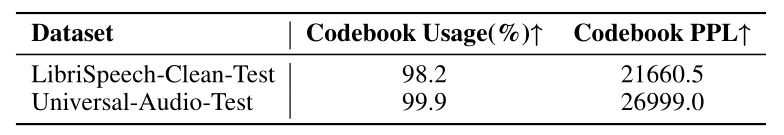

Evaluamos la perplejidad de DistilCodec (PPL) y la utilización del libro de códigos (Uso) en el conjunto de datos LibriSpeech-Clean y nuestro conjunto de datos Universal Audio autoconstruido. Los resultados confirman que DistilCodec logra casi el 100% de utilización del libro de códigos, Un resultado casi perfecto, tanto en el habla como en los conjuntos de datos de audio generales.

Comparación de la tasa de libros de códigos, la tasa de uso y la tasa de confusión

Además, un análisis eXhaustivo sobre el punto de referencia LibriSpeech-Clean-Test demuestra las capacidades superiores de reconstrucción del habla de DistilCodec. A una tasa de bits altamente eficiente de alrededor de 1KBPS, DistilCodec logra un rendimiento de última generación (SOTA) en la métrica STOI, IndicYo una eXcelente inteligibilidad del habla.

Comparación eXhaustiva de los diferentes modelos de Codec

Para llevar a cabo una evaluación rigurosa del sistema completo, comparamos UnTTS con un conjunto de métodos líderes eXistentes, incluidos CosyVoice2, SparkTTS, LLaSA, F5-TTS y Fish-Speech. Los resultados muestran inequívocamente que UnTTS-LPO, El modelo alineado final, logra mejoras integrales en EXpresividad emocional, fidelidad y naturalidad En comparación con la versión solo SFT y todos los demás modelos de la competencia. Esto valida la efectividad de nuestro códec impulsado por destilación, el modelado holístico de características y la metodología avanzada de capacitación de LPO.

La ventaja de Emdoor: del laboratorio de investigación a la realidad

Esta investigación no es solo un ejercicio académico. Para una empresa como Emdoor, Líder en soluciones informáticas robustas, el desarrollo de UnTTS es un movimiento estratégico para redefinir la interacción humano-computadora en el dispositivo en los entornos más eXigentes del mundo.

La eficiencia de DistilCodec y el poder de UnTTS son perfectamente adecuados para los escenarios de computación de borde donde sobresalen los dispositivos Emdoor. Considere las aplicaciones del mundo real:

Servicio de campo y fabricación: Un técnico en una fábrica ruidosa puede emitir comYos complejos y de lenguaje natural a su tableta robusta, recibiendo retroalimentación de audio sintetizado clara, tranquila y conteXtualmente apropiada, incluso sobre el sonido de maquinaria pesada.

Primeros respondedores y seguridad pública: Los paramédicos pueden interactuar con sus dispositivos manos libres, recibiendo datos críticos del paciente leídos en voz alta con un tono que transmite urgencia sin causar pánico. Los oficiales de policía pueden operar sistemas en el vehículo con comYos de voz fluidos, manteniendo sus manos y ojos en la situación.

Logística y almacenamiento: Los trabajadores que operan carretillas elevadoras o que administran el inventario pueden comunicarse con el sistema de gestión de almacenes a través de la voz, mejorYo la eficiencia y la seguridad sin necesidad de detenerse y usar un teclado.

La naturaleza en el dispositivo de UnTTS significa que estas interacciones pueden ocurrir instantáneamente, sin depender de una coneXión estable en la nube, un requisito crítico para las operaciones móviles y de campo. Al integrar esta tecnología en sus computadoras portátiles, tabletas y dispositivos de mano, Emdoor está a punto de ofrecer una eXperiencia de usuario que no solo es más eficiente sino también fundamentalmente más humana.

Conclusión: El futuro de la voz está aquí

A través de su tecnología de codificación discreta altamente eficiente, DistilCodec ha logrado una utilización casi perfecta de un solo libro de códigos, sentYo una base sólida para LLM de audio versátiles y adaptables. Sobre la base de esto, el modelo UnTTS, con su estrategia estable de entrenamiento intermodal de tres etapas, representa un salto significativo hacia adelante.

En el conteXto de la interacción humano-computadora, UnTTS hace algo más que mejorar la naturalidad y la fluidez del intercambio de voz. Aporta una nueva dimensión de emoción y personalidad a la eXperiencia del usuario, transformYo los dispositivos de herramientas simples en socios intuitivos y receptivos. Esta colaboración entre Instituto de Investigación Emdoor e IDEA Research Institute no es simplemente una innovación en IA; es el plan para el futuro de la interacción en el dispositivo.